先週末の1/18(日)に熱海に日帰りで旅行に行ってみた。

道の駅足柄・金太郎のふるさと

朝の9時半に自宅を出発し、高速に乗って熱海へ。

港北PAで休憩を挟みつつ、まず向かったのは道の駅足柄・金太郎のふるさと

道の駅足柄・金太郎のふるさと

道の駅足柄・金太郎のふるさと

道の駅のスタンプを押して(ちなみにスタンプはなぜか金太郎ではなくて最乗寺の天狗だったw)、ちょうど12時近くになってたのでお昼に。

注文したのは金太郎の小丼定食。

金太郎の小丼定食

金太郎の小丼定食

地魚丼とウニ牛丼がペアになった定食だったんだけど、美味しかったね。

とくにウニ牛丼がよくて、ウニのとろける味に肉の旨みが合わさる感じで最高だった。

このウニ牛丼だけたっぷり食べられるメニューもあったので、次来ることがあれば、それも食べてみたいかな。

まぁ、いいお値段ではあるんだけど(^^;

ちなみにこの日は天気がすごくよくて、高速を走りながら見えた富士山が最高だった。

道の駅足柄からの富士山;冠雪がめっちゃキレイ

道の駅足柄からの富士山;冠雪がめっちゃキレイ

MOA美術館

道の駅を出たらここからは下道(と一部は有料道路)を走って熱海へ。

途中からは海沿いの道になったりもして、景色がよくて最高だった。

で、国道135号の途中、伊豆山交差点を右に折れて向かったのは、MOA美術館。

今回熱海に行こうと思った理由の1つは、ここで開催されてた「光る海 吉田博展」を見たかったからというのがある。

細くて急勾配の道を進んで、MOA美術館の第2駐車場へ。

ぐんぐん登ったこともあって、かなりの眺め。

MOA美術館の第2駐車場から

MOA美術館の第2駐車場から

入館チケットを購入したら中へ。

能楽堂とかもあって立派

能楽堂とかもあって立派

黄金の茶室・・・

黄金の茶室・・・

サザエさんにしか見えない像もw

サザエさんにしか見えない像もw

2階には重厚なゲートがあり、そこを通って展示室へ。

各展示はガラスの奥に飾られてたんだけど、このガラスが本当に透き通ってて、まるでガラスがないように感じられるほど。

このガラスもすごかったなぁ。

そして写真も基本的に撮ってOKということだったので、嬉しかった。

まず飾られてたのが帆船の絵だったんだけど、その解説を読んでさっそくなるほどと唸らされた。

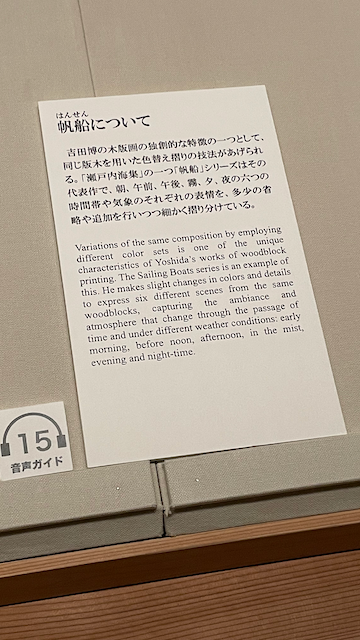

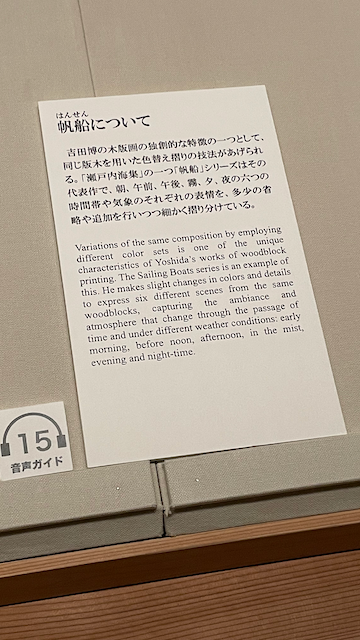

帆船の解説

帆船の解説

版画という特性を活かし、刷りの色を変えることで、同じ構図でも色合いの変わった一連の絵を作れるというのは、なるほどという感じ。

モネ展で連作という手法を見て、同じ自然の移りゆく様子を描く手法もなるほどと思ったけど、それと同じようなことを版画で実現しているというのは、まさに目から鱗だった。

しかもそれがとても効果的で、いやぁ、見事として言いようがない。

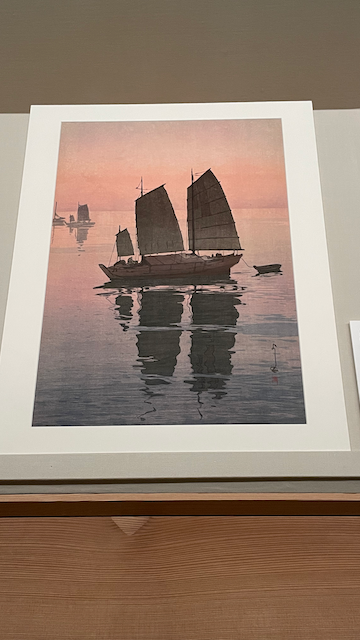

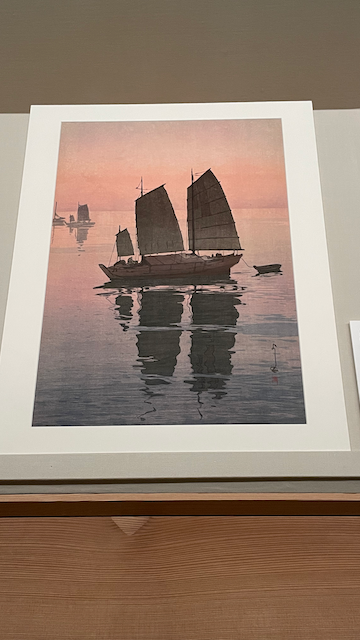

帆船 午前

帆船 午前

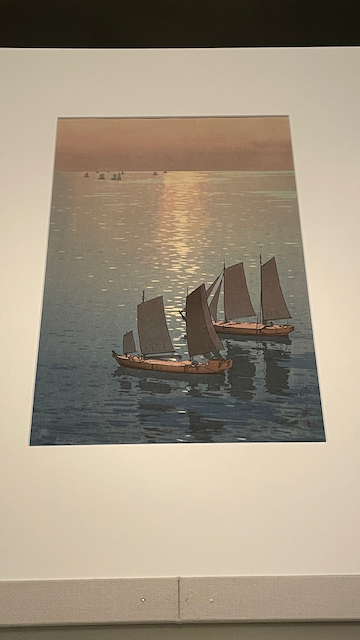

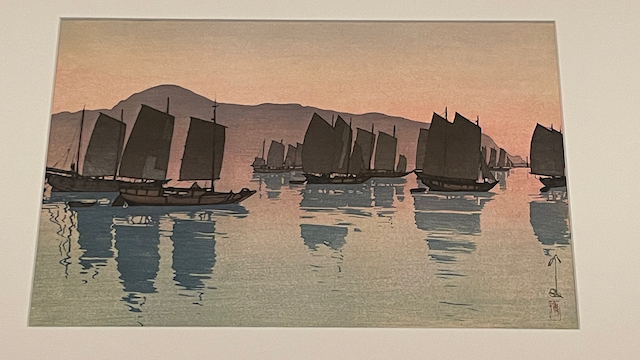

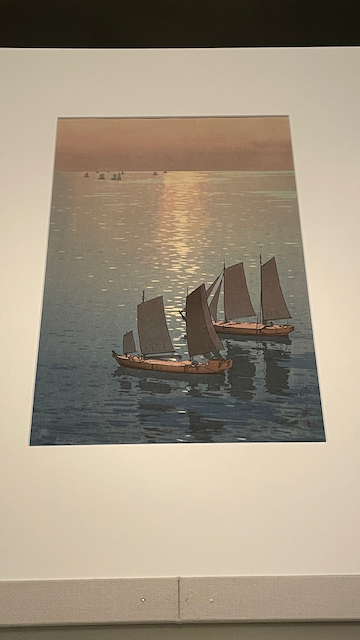

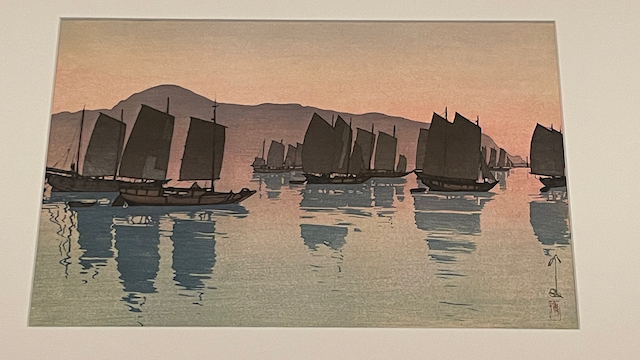

帆船 夕

帆船 夕

朝、午前、午後、霧、夕、夜と、時間の移ろい、天気の変わり方で、色彩が変化する様子が捉えられてて、ここではとりあえず2枚を載せたけど、同じ版木を使った絵でもここまで印象を変えられるのかと驚かされる。

光る海

光る海

展示会のタイトルにもなってる絵。

この海の煌めきは丸ノミで掘ることで表現されてるとのこと。

巧い表現よねぇ。

あと、奥は紙の色を使って光を表現し、逆に手前は濃い青を使って影を表現してて、その変化のさせ方とか面白いと思った。

個人的にすごくいいなと思ったのは阿武兎(あぶと)の朝という作品。

阿武兎の朝

阿武兎の朝

陸と海との境界が曖昧になっていて、柔らかな色が幻想的。

逆光で影を落とす帆船に、凪いだ海面が描かれていて、とても穏やかな雰囲気が伝わってくる。

こういうのって写真だと表現難しいと思っていて、印象を映し出すというか、絵画ならではだよなぁと思ったり。

この写実と観念との間にあるというのは、他の作品でも感じたり。

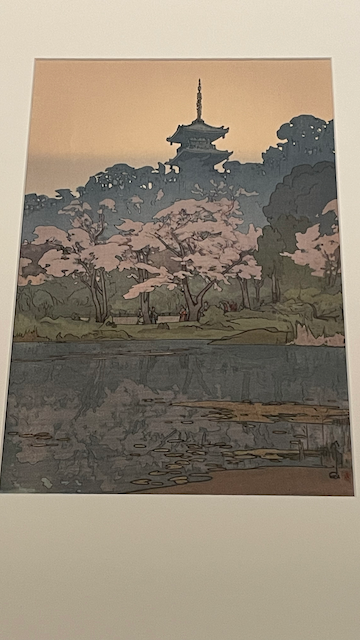

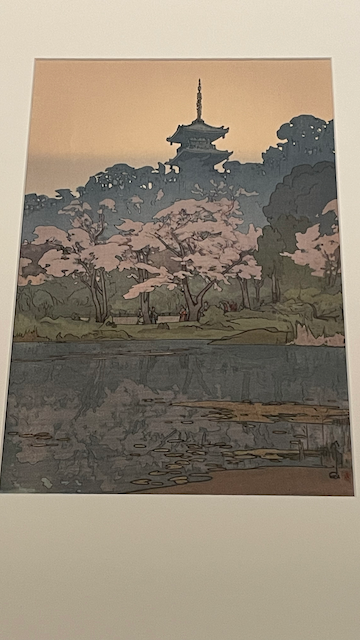

三溪園

三溪園

実際の風景を元にはしてるだろうけど、現実そのものではなくてイラストらしくなってるというのも感じられて、その観念的な描画とかは浮世絵の伝統からきてる部分もあるんだろうなぁとか。

あるいは逆に、すごく細かい表現で唸らされたりも。

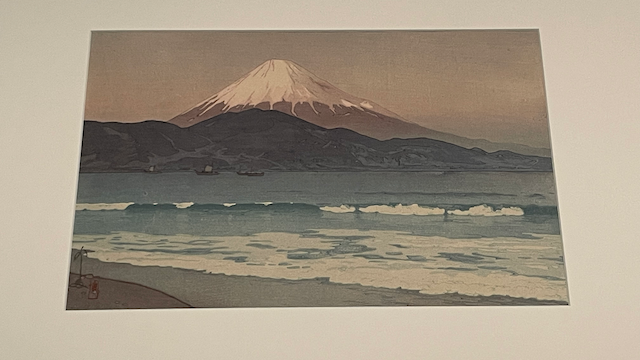

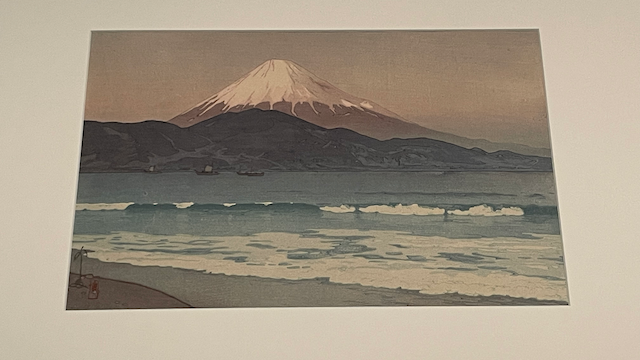

三保

三保

富士山自体もキレイなんだけど、この絵の波の表現が凄くて、そうそう、波ってそうなんだよなぁ、この瞬間を切り取りたいって思うんだよなぁと。

波が崩れる瞬間の描画がたまらない

波が崩れる瞬間の描画がたまらない

日光東照宮の陽明門の絵とかも、細かい色の重なりが凄かった。

陽明門の細かい表現

陽明門の細かい表現

あと、欧米やアジア諸国を巡ったりもしたらしく、そこで描かれた絵も。

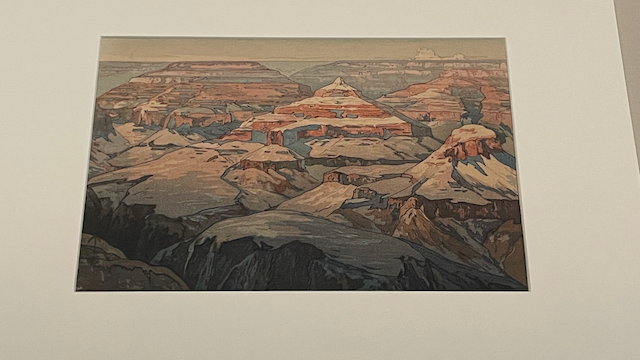

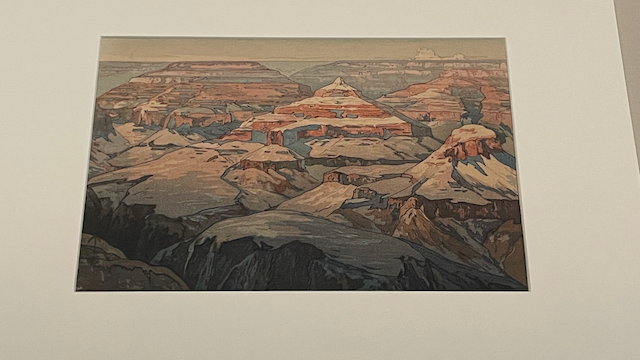

ただ、海外のはずなのにどこか日本的にも感じられたりして、それも面白かった。

やっぱり観念として見た世界を絵にしているところはあったんだろうなぁ。

エアーズロック;どことなく日本らしさを感じられる

エアーズロック;どことなく日本らしさを感じられる

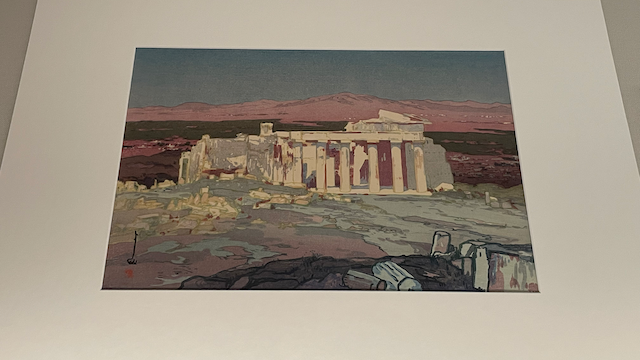

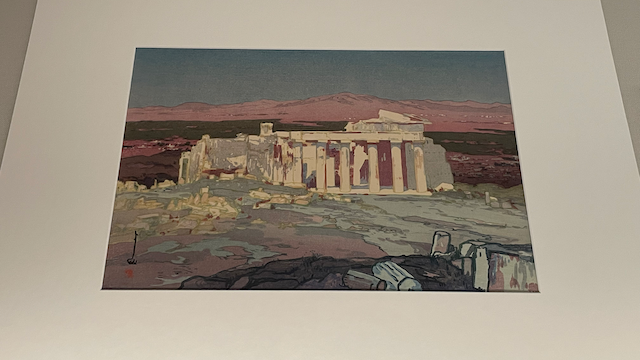

ちなみに、しっかり海外だなと感じられる絵も。

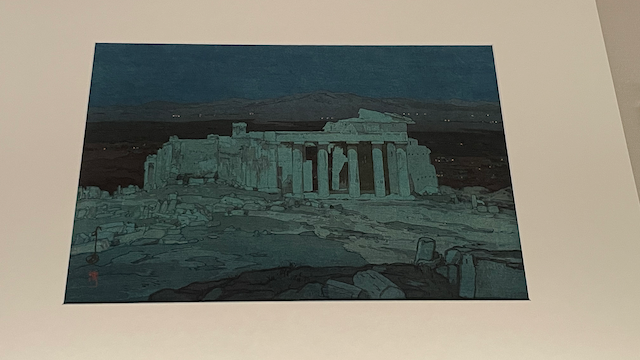

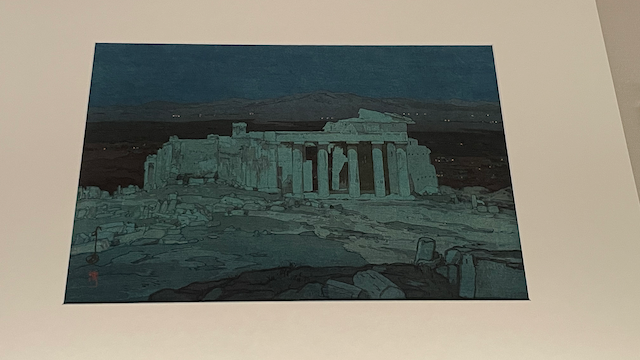

アゼンスの古跡は色替えの手法も用いられててすごくよかった。

アゼンスの古跡

アゼンスの古跡

アゼンスの古跡 夜

アゼンスの古跡 夜

そんな感じでかなり満喫できた。

いやー、いい展覧会だったなぁ。

ちなみに美術館の外に出ると立派な建物が見れて、眼下に広がる熱海の景色も一望できる。

MOA美術館の外観

MOA美術館の外観

熱海の街と海を見下ろせる

熱海の街と海を見下ろせる

MOA美術館のあとは来宮神社(きのみやじんじゃ)へ。

来宮神社の鳥居

来宮神社の鳥居

来宮神社の拝殿

来宮神社の拝殿

ここは大楠が有名。

来宮神社の大楠

来宮神社の大楠

めっちゃ大きくて凄い

めっちゃ大きくて凄い

周りをぐるっと回れるんだけど、凄かったなぁ。

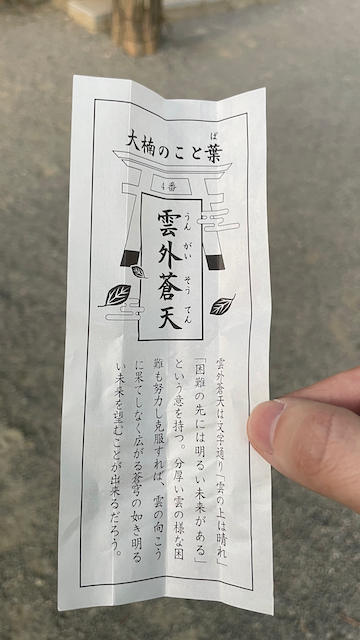

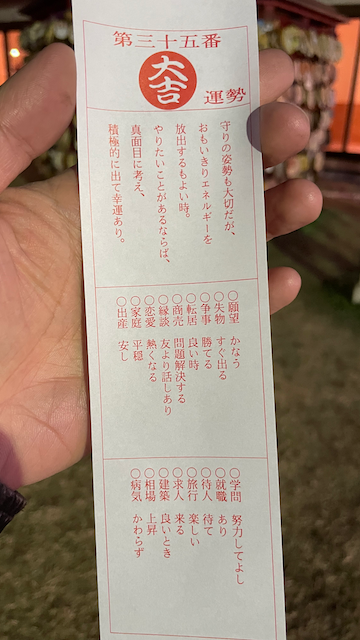

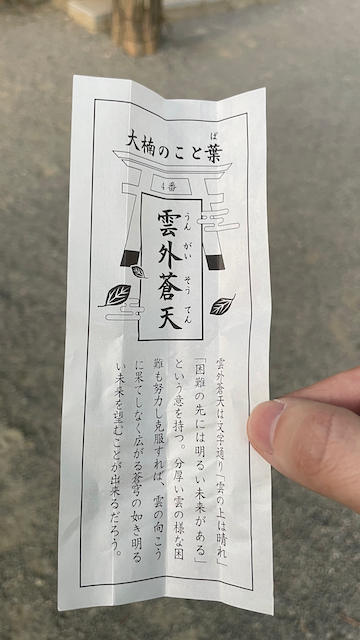

大楠を模したおみくじも

大楠を模したおみくじも

やっぱり努力が大事そう

やっぱり努力が大事そう

オーシャンスパFuua

最後に向かったのはオーシャンスパFuua。

駐車場とかよく分かってなかったけど、熱海後楽園ホテルの駐車場に向かえばよかったっぽい。

ホテル付近からの熱海の眺め

ホテル付近からの熱海の眺め

ホテル付近の様子;熱海城も見える

ホテル付近の様子;熱海城も見える

駐車場に入っていくと係の人がいて案内してくれた。

立体駐車場でオーシャンスパを使えば5時間まで500円という感じ。

オーシャンスパFuuaの入口

オーシャンスパFuuaの入口

かなり立派な施設で、お風呂はもちろん、岩盤浴とかリラックスペース、コワーキングスペースみたいのもある感じ。

値段としてはけっこうするけど、館内着やタオル類もついてくるので、妥当ではあるのかな。

さっそくお風呂に向かったんだけど、このお風呂がとてもよかった。

露天風呂が独特で、外に出るとベランダにあたる部分がマルッとお風呂になっている感じ。

立ちながら入れるほどの深さもあって、海と熱海の街並みを眺めながらゆったりと入れる。

ちょうど日も暮れて、このお風呂に入りながら見えた熱海の夜景がめちゃくちゃキレイだった。

温泉もよかったし。

サウナはまぁまぁという感じだったけど、ゆったりと休めたなぁ。

お風呂のあとは夕飯。

隣接の後楽園ホテル(というかFuuaがホテルの隣接なんだけど)のレストランに通路で移動した。

注文したのは牛ロースステーキ。

牛ロースステーキ

牛ロースステーキ

いい焼き具合

いい焼き具合

美味しかったけど、ちょっと高かったかな(^^;

もうちょいメニューがいろいろあると選べてよかったんだけど。

このあとはリラックススペースで軽く仮眠して、もう一度お風呂を堪能したあと、21時頃に熱海を離脱。

途中、港北PAで少し休憩もしつつ、3時間弱で帰宅。

美術館とかご飯とかお風呂とか、けっこうお金を使ったけど、熱海よかったなぁ。

ドライブとしてもちょうどいいくらい。

あと、熱海に来る前にちょっと左手首が痛い感じがあったんだけど、温泉の効果なのか、痛みがだいぶ和らいだ感じがあった。

有名な温泉だけあって、効能もやっぱり凄いのかなぁと感心。

今日はここまで!